האפס והאחד / ליאור זלמנסון

מ(י)שהו רואה אותי?

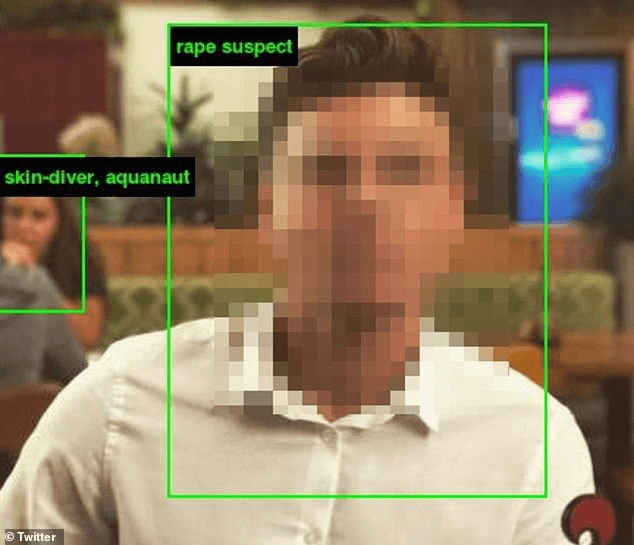

בחודש האחרון, אלפי אנשים מעלים את תמונותיהם לפייסבוק כשמסביב לתמונות ריבוע עם כיתוב מסתורי. על תמונה של ידידה שלי היה כתוב "מוזרה, קריפית, מפחידה". על תמונה אחרת של גבר הופיע הכיתוב "עבריין". העובדה שאנשים מתגאים בתיוגים אלו היא רק שלב נוסף ומטריד בעבודה המרתקת של האמן טרוור פגלן והחוקרת קייט קרופורד אשר חוקרים את הסוגיות החברתיות והאמנותיות בתחום הראייה הממוחשבת - אחד התחומים המרכזיים בחקר הבינה המלאכותית. ביחד הם בוחנים: כיצד מחשבים מסתכלים על העולם ובמיוחד עלינו?

פגלן וקרופורד השיקו החודש ב-Prada Fundazione במילאנו את הפרוייקט עם השם הדו משמעי Training Humans, שעוסק בנעשה בעולם זיהוי התמונה הממוחשב. מצד אחד, בני האדם הם הקלט, חומר האימון המוגש למכונה, כדי שיוכלו ללמוד לזהות אותנו. קחו לדוגמא את האופן בו אנו מגישים לחברת ׳אפל׳ את הסלפי שלנו כדי שהזיהוי הביומטרי (תמונת הפנים) יחסוך מאיתנו את הקלדת הסיסמא. מצד שני, מדובר בעתיד שלנו, שכן תהליכי זיהוי התמונה והאופן שבו מחשבים "יקלטו" אותנו הם שיגדירו בעתיד את היחס שנקבל. בעולם העתידי מצלמות ממוחשבות יחליטו על פי זיהוי פנינו אם לפתוח לנו דלתות, ניתוח הפנים יסייע לרובוטים ממוחשבים להבין איך לשרת אותנו, ורבים מאיתנו ייעזרו במערכות ממוחשבות לניתוח פנים כדי ללמוד עוד על המועמד/ת לעבודה או לדייט. החשש מהטיות של האלגוריתמים הינו ממשי שכן תוצאותיו בעתיד יכולות להיות הרות אסון. פגלן וקרופורד מבקשים להזכיר לנו שהתהליכים הממוחשבים לזיהוי אובייקטים בתמונה אינם טכניים אלא פוליטיים במהותם. משמע, כל בחירה שמפתחי האלגוריתמים עושים, גם אם לכאורה נעשית מטעמי יעילות ושיפור "ההצלחה בזיהוי", מסתירה בפועל הבניות חברתיות מרובות.

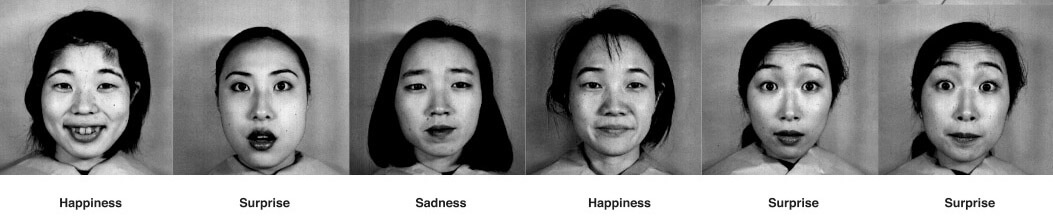

במאמר excavating.ai שפרסמו לרגל התערוכה הם נותנים את הדוגמא של מסד התמונות JAFFE. זהו מאגר תמונות הכולל הבעות פנים של נשים יפניות, שנוצר לצורך אימון מחשבים בזיהוי רגשות. בפועל, מדעני המחשב שיצרו את המאגר ביצעו מספר בחירות קריטיות. הם החליטו למשל על שישה מצבים רגשיים בסיסיים: עצב, שמחה, פחד, הפתעה, כעס, גועל לצד תמונת פנים המביעה ניטרליות. חשבו לרגע, למשל, מהו פרצוף ניטרלי? האם אפשר לדבר על פרצוף ניטרלי של אנשים שונים? של גילאים שונים? מגדרים או תרבויות שונות (אפילו בתוך החברה היפנית)? כמו כן, האם בכלל זיהוי רגש בפני האדם הוא מפתח להבין איך האדם מרגיש? או אולי אנחנו רק "מציגים" הבעת פנים בציבור שאינה קשורה בכלל לרגש?

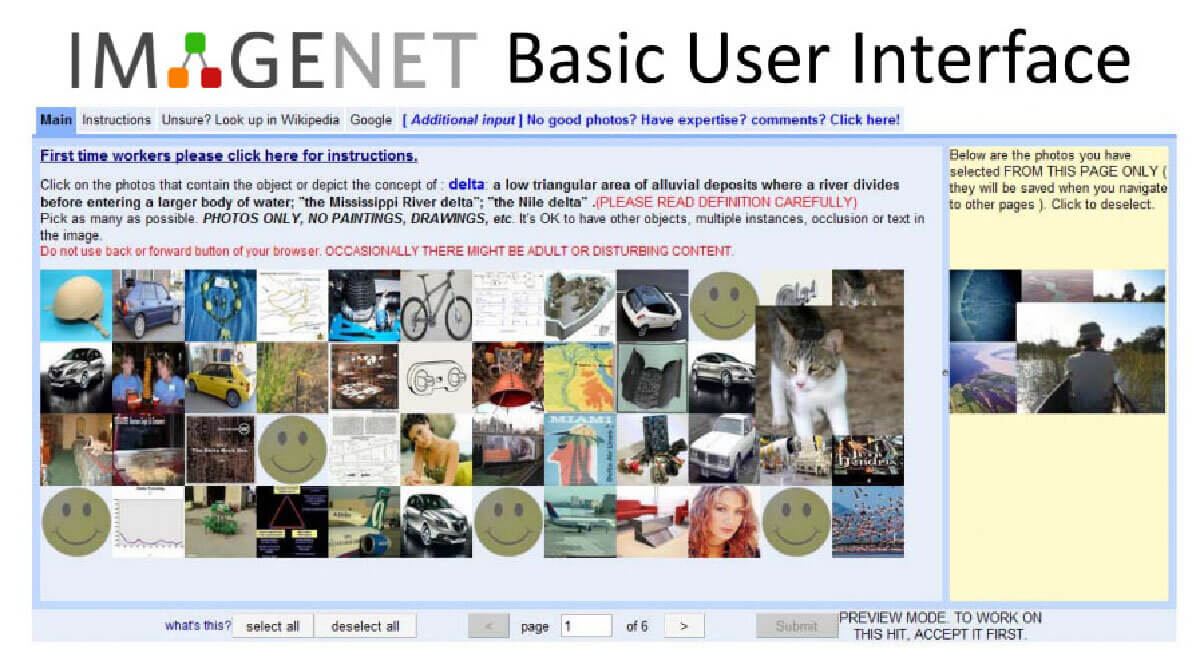

העבודות של פגלן וקרופורד בתערוכה מבוססות על מאגר נרחב ומטריד עוד יותר, ה-ImageNet. מנגנון תמונות הכולל יותר מ-14 מיליון תמונות של כל דבר שאתם יכולים לחשוב עליו. כדי ליצור את התיוג, כלומר להבין את המשמעות הראשונית של התמונה, נעזרו החוקרים שיצרו את המאגר במיקור המונים (הפניה לביצוע משימה לקהל גדול). הם פנו לאתר Amazon Mechanical Turk שם ניתן לגייס "עובדים" לעבודות פשוטות של דקות ספורות, וביקשו מהם לתייג את התמונה. בעוד שאובייקטים כמו תפוח ותפוז הם ברורים, כיצד תתייגו תמונה של אדם שאינכם מכירים? עובדים רבים אשר עבדו בעבודה המשמימה עבור סנטים בודדים, תייגו את התמונה לפי איך שהאדם נראה בעיניהם, לרבות שימוש בסטריאוטיפים ואף גידופים.

פגלן וקרופורד השתמשו בזה והמציאו את ה-Imagenet Roulette - בעצם העבודה המרכזית שמוצגת בתערוכה - שבה כל אחד ואחת מהצופים יכולים לעלות את תמונתם. אלגוריתם הזיהוי שתכננו עשה שימוש באותו Imagenet וכתוצאה מכך נתן למשתמשים תיאור של עצמם אשר לעיתים כלל אמירות לא מחמיאות כמו אלו שתוארו בפסקה הראשונה של טור זה. עבור רבים, זה היה המפגש הראשון עם תהליכי זיהוי תמונה, והבנה שהמחיר של אימון לקוי - מבחינת איכות התמונות והתיוג - עלול להוביל לתוצאות קטסטרופליות לגביהם. מכיוון שתהליכים אלו לא שקופים ולא נהירים למשתמשים, אך נמצאים בשימוש נרחב, עבודתם של פגלן וקרופורד מציבה מראה (ממוחשבת) אשר מעמתת את הצופה וקוראת לו לפעול ולדרוש ביקורת ציבורית על טכנולוגיות אלו. העבודה כבר זכתה להשפעה ציבורית כשהאנשים מאחורי מאגר ImageNet החליטו לעשות מעשה ולהוריד חלק מהתמונות, התיוגים והקטגוריות הבעייתיות.

נושא זה מעסיק אף אותי בשנה האחרונה. בעבודה Image May Contain שהצגתי לאחרונה בתערוכת היחיד NewSpeak במשכן האמנים בהרצליה, בחנתי את הדרך בה מנגנון זיהוי התמונה של פייסבוק עובד. בשנת 2017 הם השיקו מנגנון בשם Automatic Alternative Text שמקריא לעיוורים מה רואים בתמונה שמופיעה בפיד שלהם בפייסבוק. שלא כמו ה-Imagenet, המנגנון של פייסבוק יכול לזהות רק מעט מאד. הוא מזהה מספר אנשים (בהצלחה חלקית), האם הם יושבים או עומדים, נוכחות של מכונית או עצים, חוץ/פנים ודברים בסיסיים ביותר. בעבודתי רציתי לבחון מה באמת עיוורים ילמדו מחברת פייסבוק על העולם כשישתמשו באופציה זו. הזנתי את התמונה המפורסמת שצולמה רגע לפני ההתנקשות ב-JFK והאלגוריתם אמר "10 אנשים, מכונית". שחזור רצח רבין הפך להיות "שלושה אנשים עומדים" והפלישה לנורמנדי הפכה ל"איש אחד או יותר, חוץ, מים". לאחר מכן גיליתי שבעזרת חיפוש מתוחכם בפייסבוק ניתן למצוא עוד תמונות שזוהו באותו אופן על ידי האלגוריתם ויצרתי תמונות לנטיקולריות (מנגנון הדפסה בשתי וערב, המייצר לרוב תחושה של תזוזה, כמו הגלויות שניתן לקנות בכל מוזיאון). בכל תזוזה של המבקר מתגלה תמונה חדשה, רצח רבין הופך למשל לסלפי של שלוש בחורות מהאמירויות. גם הן זוהו כ "שלושה אנשים עומדים". כתוצאה, המחשב נחשף בעיוורונו או שמא ביכולתו ליצור חיבורים חדשים, מקוריים ובעייתיים בתמונות ההיסטוריות שלנו (לינק לתיעוד העבודה: https://bit.ly/2APo15E).

אולי יש בכך איזה משהו מרגיע, לדעת שהבינה המלאכותית המוצלחת עוד לא כאן, ועוד יש תפקיד חשוב לעיניים האנושיות ולאוצר העשוי בשר ודם. אבל יש לזכור - כפי שפגלן וקרופורד מלמדים אותנו - שכבר כיום האלגוריתמים האלה, על שלל חסרונותיהם, מסדרים לנו את העולם הממוחשב לפי הבנתם, ובקרוב השפעתם תהיה נוכחת בכל מימד של עולמנו הגשמי.